Understanding the Tricks of Deep Learning in Medical Image Segmentation: Challenges and Future Directions

1 研究动机

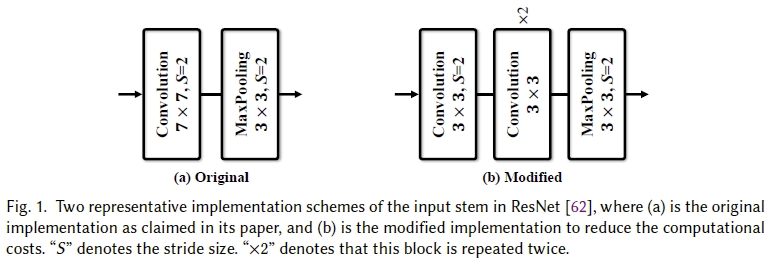

我们这篇论文的出发点是想要解决大家一直以来诟病的一个问题,即深度学习模型的architecture和setting过于复杂,导致实验结果的比较存在不公平性。举个常见的栗子,比如大家都会用到的ResNet,几乎每个人都会在论文中说“Our backbone network is ResNet-50 or ResNet-101.”, 但是其实在部署的时候,ResNet的input stem存在两种不一样的形式,如下图:

其中,(b)是在(a)上面的一个改进,用于减少计算量的。这种改进被证实是可以显著的影响模型的识别精度的,但是少有人在自己的论文中介绍backbone network的时候提及这种改进。那么,基于这两种不一样形式的backbone的实验结果比较,显然是不公平的。

2 研究方法

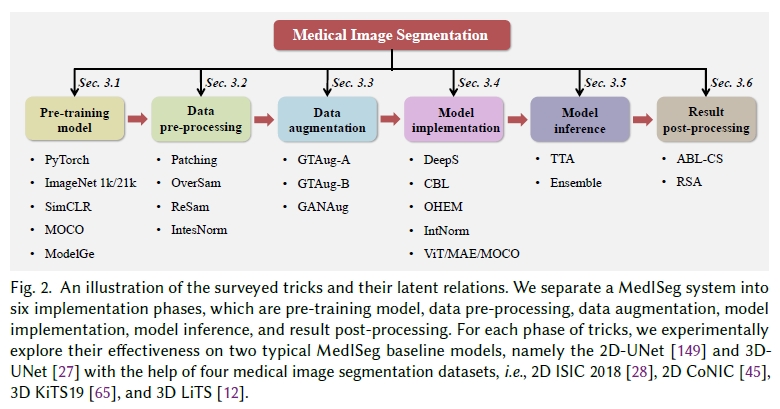

我们首先收集了一系列针对不同模型部署阶段的Tricks,这些Tricks主要可以被划分为以下6个方面:

其次,在这些Tricks的基础上,我们通过实验探索了这些Tricks在一致的基准模型和数据集上对于实验结果的影响。为了能全面的覆盖2D和3D数据,我们以医学图像语义分割数据为实验对象,选择了4个常用的医学图像语义分割数据集,即2D ISIC 2018,2D CoNIC,3D KiTS19和3D LiTS,所采用的基准模型分别是2D-UNet和3D-UNet。

MedISeg的优势

1). 我们的工作提供了大量扎实的实验,在技术上更具有更强的可操作性和更现实的指导性

2). 通过在2D和3D数据集上的大量实验,我们明确地阐明了这些Tricks对于实验结果的影响

3). 基于所调查的Tricks,我们开源了MedISeg源码和预训练模型库,其全面的覆盖了2D、3D数据集以及不同的语义分割方法

3 研究结论

Tricks本质上对应的是解决了语义分割任务中的一些Challenges。在本文中,我们主要围绕small dataset learning, class imbalance learning, multi-modality learning, 和domain adaptation四个方面展开了讨论。每一个Trick对应的Challenges分析请查看原文的Section 4。此外,Tricks的不同部署策略会带来效果上的差异。在本文中,我们对数据扩增中的策略展开讨论,发现不同的数据扩增方法组合在同样的数据集上带来的提升略有差异。另外,同样的策略在不同的数据集上也有有差异,这说明我们在选择Tricks的时候,还需要考虑到数据集本身的状况。比如当我们选择损失函数对应的Tricks的时候,选择的Tricks本质上是解决了class imbalance learning的问题,但要是我们的数据集中没有这个问题,那么这么Tricks就不能起到我们预想的效果。这其实也可以回答大家之前的一个疑问,为什么有些Tricks加在模型中是有效的,而有些是没有效果的,甚至有些时候Tricks之间好像是存在部署上的冲突的。本质原因就是由于Tricks解决的Challenges导致的。

4 未来的方向

对于本文研究的内容以及面向医学图像语义分割任务,将来可以在以下几个方面继续展开研究:

1). 调研和开发更多的面向医学图像语义分割的tricks。

2). 继续在更多的方法和数据集上探索其他tricks的有效性。

3). 前面提到的,tricks其实对应的是解决了语义分割任务中的一些Challenges。那么反过来,我们其实也可以利用tricks来指导我们的模型设计,使得我们的模型也具有“又好又快”的效果。